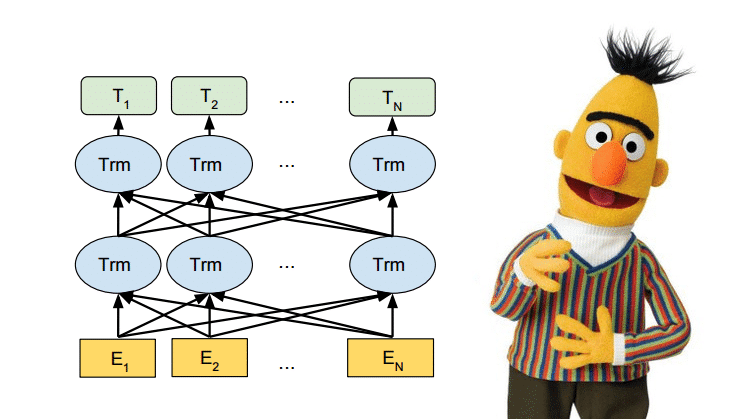

ALBERT: Bé hạt tiêu của dòng họ Transformer

Trung tâm nghiên cứu của Google và Viện công nghệ Toyota đã cùng nhau xuất bản bài báo giới thiệu về một mô hình được coi là người kế vị của BERT, một mô hình hiệu quả hơn với số lượng tham số ít hơn nhiều. Mô hình này có tên là ALBERT (A Lite … Đọc tiếp