Trong thế giới của trí tuệ nhân tạo (AI) và học máy (ML), vai trò của GPU (Graphics Processing Unit) ngày càng quan trọng. GPU đã cách mạng hóa lĩnh vực này bằng cách tăng tốc quá trình huấn luyện và suy luận của các mạng nơ-ron phức tạp. Hướng dẫn toàn diện này sẽ khám phá tầm quan trọng của việc lựa chọn GPU phù hợp cho dự án AI và ML của bạn. Dù bạn là nhà nghiên cứu, nhà phát triển hay nhà khoa học dữ liệu, việc hiểu kiến trúc GPU và đưa ra lựa chọn thông minh là yếu tố then chốt cho thành công của công việc của bạn.

Việc lựa chọn GPU phù hợp sẽ có ảnh hưởng lớn đến hiệu suất, hiệu quả và tính chi phí cho dự án AI và ML của bạn. Hãy cùng trituenhantao.io tìm hiểu cách chọn đúng GPU trong bài viết này.

Kiến trúc GPU và ý nghĩa trong Học máy

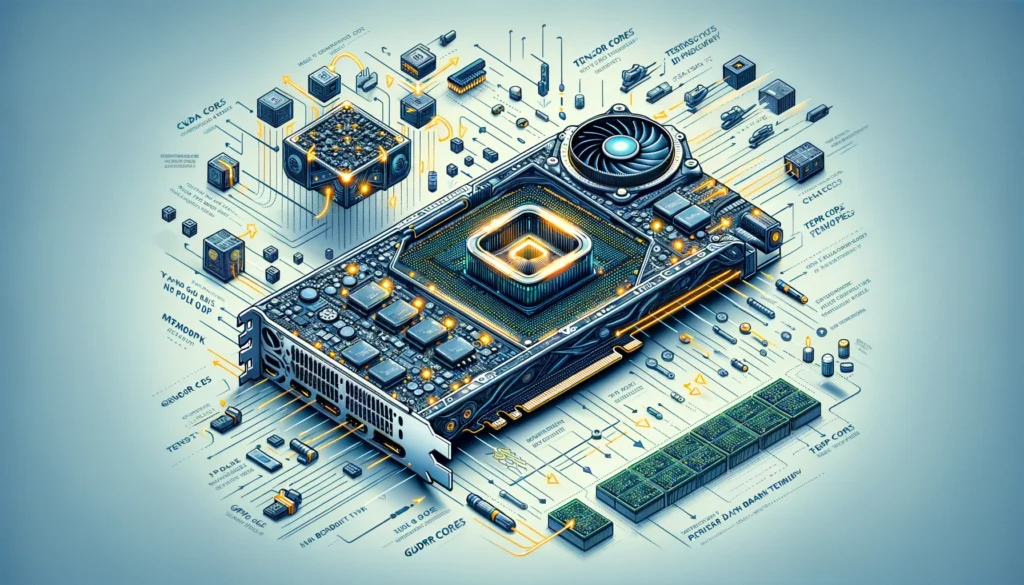

Nắm bắt được những kiến thức cơ bản về kiến trúc GPU là điều cần thiết để lựa chọn GPU tốt nhất cho AI và ML năm 2024. Các thành phần chính của GPU bao gồm các nhân xử lý, hệ thống bộ nhớ phân cấp và các kết nối.

CUDA Core, Tensor Core và Băng thông bộ nhớ

CUDA (Compute Unified Device Architecture) là trái tim của sức mạnh xử lý GPU. Các nhân CUDA thực hiện các phép tính toán học quan trọng cho các tác vụ AI và ML. Việc hiểu số lượng nhân CUDA và hiệu quả của chúng trong GPU của bạn là điều cần thiết.

Tensor Core, một tính năng mới được thêm vào một số GPU, được thiết kế đặc biệt cho các tác vụ học sâu. Chúng vượt trội trong các phép toán ma trận thông thường trong các phép tính mạng nơ-ron. GPU được trang bị Tensor Core có thể giảm đáng kể thời gian huấn luyện cho các mô hình học sâu.

Băng thông bộ nhớ liên quan đến việc đọc và ghi dữ liệu trên bộ nhớ GPU nhanh chóng. Băng thông bộ nhớ cao rất quan trọng trong AI và ML, nơi các bộ dữ liệu lớn thường gặp. GPU có băng thông bộ nhớ đủ lớn có thể xử lý hiệu quả lưu lượng dữ liệu cần thiết cho việc huấn luyện và suy luận, giảm thiểu độ trễ.

Các sự lựa chọn hàng đầu: Đánh giá các GPU tốt nhất cho AI năm 2023

Hãy cùng đánh giá sâu về các đối thủ hàng đầu trong thị trường GPU AI năm 2023, từ những sản phẩm mới nhất của NVIDIA cho đến sự cạnh tranh của AMD và sự xuất hiện của những người chơi mới.

Phát triển mới nhất từ NVIDIA

NVIDIA đã trở thành một thế lực chi phối trong thị trường GPU AI và học máy. Các sản phẩm mới nhất của họ tiếp tục đặt tiêu chuẩn về hiệu suất và đổi mới. GPU NVIDIA A100, dựa trên kiến trúc Ampere, có số lượng lớn các nhân CUDA và Tensor Core, tạo nên một cỗ máy mạnh mẽ cho các tác vụ học sâu. Dòng NVIDIA RTX 40 Series, hướng đến giới game thủ và những người đam mê AI, giới thiệu các tính năng đột phá như dò tia thời gian thực và tính năng AI nâng cao. Những GPU này không chỉ nhanh chóng mà còn được trang bị các tính năng dành riêng cho AI, có thể nâng cao chất lượng dự án AI của bạn.

Đáp trả từ AMD

AMD, được biết đến với sự cạnh tranh mạnh mẽ với NVIDIA, cũng đã có những bước tiến đáng kể trong thị trường GPU AI. Dòng Radeon Instinct của họ, sử dụng kiến trúc RDNA, đã thu hút được sự chú ý đối với tỷ lệ giữa giá và hiệu năng của nó. Mặc dù AMD có thể có thị phần khác biệt so với NVIDIA, GPU của họ mang lại một lựa chọn hấp dẫn cho những ai tìm kiếm giải pháp tiết kiệm chi phí mà không làm giảm hiệu suất AI. Hãy để ý đến các sản phẩm mới của AMD, vì họ luôn đổi mới và có thể làm thay đổi cục diện GPU.

Ngoài NVIDIA và AMD, năm 2023 có nhiều đối thủ mới xuất hiện trong thị trường GPU AI. Intel với GPU của họ hướng đến việc gây ấn tượng trong lĩnh vực AI và ML. Sự kết hợp giữa giải pháp phần cứng và phần mềm của Intel có thể mang lại lợi thế độc đáo cho một số tác vụ AI. Graphcore và Habana Labs cũng thiết kế các bộ xử lý AI đặc biệt nhằm mục tiêu các tác vụ AI chuyên biệt. Mặc dù những lựa chọn này có thể không có độ nhận diện thương hiệu như NVIDIA hay AMD, chúng vẫn đáng để xem xét, đặc biệt là đối với các ứng dụng AI cụ thể mà kiến trúc của chúng vượt trội.

Đánh giá hiệu năng: Cách so sánh GPU cho Học máy

Việc lựa chọn GPU phù hợp cho học máy là một quyết định then chốt, vì nó ảnh hưởng trực tiếp đến tốc độ, hiệu quả và tính chi phí hiệu quả của dự án AI của bạn. Để hỗ trợ quá trình ra quyết định này, các tiêu chí đánh giá hiệu suất (performance benchmarks) rất quan trọng để đánh giá GPU trong bối cảnh học máy.

Tốc độ xử lý

Tốc độ xử lý là một yếu tố quan trọng khi so sánh GPU cho học máy. Số lượng nhân CUDA, tốc độ xung nhịp và hiệu quả kiến trúc đều góp phần vào sức mạnh xử lý của GPU. Tìm kiếm các chỉ số đánh giá và hiệu năng chuyên dành cho các tác vụ học máy, vì chúng cung cấp hình ảnh chính xác hơn về khả năng của GPU cho các tác vụ AI. Hãy nhớ rằng không phải tất cả các tác vụ AI đều yêu cầu tốc độ xử lý cao nhất, vì vậy hãy chọn một GPU phù hợp với yêu cầu cụ thể của dự án của bạn.

Dung lượng bộ nhớ và Băng thông

Học máy thường liên quan đến việc xử lý với các bộ dữ liệu lớn, do đó dung lượng bộ nhớ và băng thông trở nên rất quan trọng. GPU có dung lượng VRAM đủ lớn có thể xử lý các bộ dữ liệu lớn mà không cần chuyển dữ liệu thường xuyên giữa bộ nhớ hệ thống và bộ nhớ GPU. Băng thông bộ nhớ cao đảm bảo rằng dữ liệu có thể được truy cập nhanh chóng, giảm độ trễ trong quá trình huấn luyện. Đánh giá thông số bộ nhớ của GPU trong việc so sánh của bạn để đảm bảo chúng đáp ứng được yêu cầu bộ nhớ của dự án.

Hiệu quả năng lượng và Yêu cầu làm mát

Hiệu quả năng lượng không chỉ có ý nghĩa về mặt môi trường mà còn ảnh hưởng đến tổng chi phí sở hữu. GPU có hiệu quả năng lượng cao hơn sẽ phát sinh ít nhiệt hơn, giảm yêu cầu về giải pháp làm mát phức tạp. Khi chọn GPU cho học máy, hãy xem xét khả năng cung cấp năng lượng và làm mát của hệ thống của bạn. GPU “thèm” điện có thể yêu cầu nâng cấp hệ thống để hoạt động tối ưu, từ đó làm tăng chi phí tổng thể.

Giá và hiệu suất: Tìm kiếm GPU AI có giá trị tốt nhất

Các lựa chọn giá rẻ với tỷ lệ hiệu suất trên giá thành cao

Khi tìm GPU AI phù hợp với ngân sách, điều quan trọng là xác định các lựa chọn có hiệu năng ấn tượng mà không khiến bạn phải chi ra quá nhiều tiền. Dưới đây là một số GPU có giá thành rẻ nhưng lại nổi bật về tỷ lệ hiệu suất trên giá thành:

- NVIDIA GeForce GTX 1660 Super

- AMD Radeon RX 6700 XT

- NVIDIA GeForce RTX 3060

Các lựa chọn cao cấp cho hiệu suất không thỏa hiệp

Đối với những người yêu cầu hiệu suất GPU AI hàng đầu, các lựa chọn cao cấp sẽ cung cấp công nghệ tiên tiến nhất để đẩy giới hạn của dự án AI và học máy của bạn. Dưới đây là một số GPU cao cấp được xem là biểu tượng của hiệu suất không thỏa hiệp:

- NVIDIA A100

- NVIDIA GeForce RTX 3090

- AMD Radeon Instinct MI200

Lựa chọn giữa GPU giá rẻ và cao cấp cuối cùng phụ thuộc vào yêu cầu cụ thể và giới hạn ngân sách của bạn. Lựa chọn phù hợp sẽ giúp bạn giải quyết hiệu quả các tác vụ AI và học máy mà không tốn quá nhiều chi phí.

Kết luận

GPU AI không phải là ngoại lệ trong một thế giới mà công nghệ phát triển nhanh chóng. Các lựa chọn và khả năng ngày càng mở rộng, khiến việc cập nhật và thích ứng với những đổi mới mới nhất trở nên cần thiết.

Ngoài những sản phẩm đã được đề cập ở trên, NVIDIA còn tiếp tục hợp tác với Microsoft để xây dựng cơ sở hạ tầng AI hàng đầu. Microsoft đã giới thiệu thêm máy ảo dựa trên H100 và H200 trên Microsoft Azure để đẩy nhanh các tác vụ AI đòi hỏi hiệu suất cao.

Tại hội nghị Ignite diễn ra tại Seattle, Microsoft đã công bố chuỗi máy ảo mới NC H100 v5 cho Azure, đây là loại máy ảo điện toán đám mây đầu tiên trên thị trường sử dụng GPU NVIDIA H100 NVL. Thuê máy chủ ảo này kết hợp hai GPU H100 dựa trên PCIe được kết nối thông qua NVIDIA NVLink, với gần 4 petaflops khả năng tính toán AI và 188GB bộ nhớ HBM3 nhanh hơn. GPU NVIDIA H100 NVL có thể đạt hiệu suất cao hơn từ 12 lần trên GPT-3 175B so với thế hệ trước và rất phù hợp cho các tác vụ suy luận và huấn luyện chính.

Bên cạnh đó, Microsoft cũng thông báo kế hoạch thêm GPU NVIDIA H200 Tensor Core vào dàn Azure của họ vào năm sau để hỗ trợ suy luận mô hình lớn hơn mà không làm tăng độ trễ. GPU H200 mới này được xây dựng đặc biệt để tăng tốc các tác vụ AI lớn nhất, bao gồm các mô hình LLM và AI sinh trắc học.

GPU H200 mang lại sự gia tăng đáng kể về dung lượng bộ nhớ và băng thông, sử dụng bộ nhớ HBM3e thế hệ mới nhất. So với H100, GPU mới này sẽ cung cấp 141GB bộ nhớ HBM3e (nhiều hơn 1,8 lần) và 4,8 TB/giây băng thông bộ nhớ tối đa (tăng 1,4 lần).

Đám mây Viễn thông Đạt được Tín nhiệm

Mở rộng khả năng sẵn có của NVIDIA trong việc đẩy mạnh tính toán AI sinh trắc học cho khách hàng Azure, Microsoft đã công bố một phiên bản máy ảo mới NCC H100 v5 hỗ trợ GPU NVIDIA.

Những máy ảo này sử dụng GPU NVIDIA H100 Tensor Core cung cấp cho khách hàng khả năng bảo vệ tính bảo mật và toàn vẹn của dữ liệu và ứng dụng trong khi sử dụng, trong bộ nhớ, và đồng thời truy cập vào tốc độ tăng tốc vượt trội của GPU H100. Các phiên bản máy ảo này sẽ sớm được đưa vào bản xem trước dành cho người dùng.

Với những đổi mới và sự hợp tác giữa các công ty hàng đầu như NVIDIA và Microsoft, người dùng có nhiều lựa chọn hơn về các GPU phù hợp để đáp ứng nhu cầu của dự án AI và học máy. Hãy cân nhắc kỹ lưỡng các yếu tố trên để đưa ra sự lựa chọn phù hợp với ngân sách và nhu cầu khách hàng.

Hãy chia sẻ bài viết này và truy cập thường xuyên trang web của trituenhantao.io cũng như các kênh thông tin khác để cập nhật thông tin kiến thức mới nhất về lĩnh vực AI và Machine Learning.