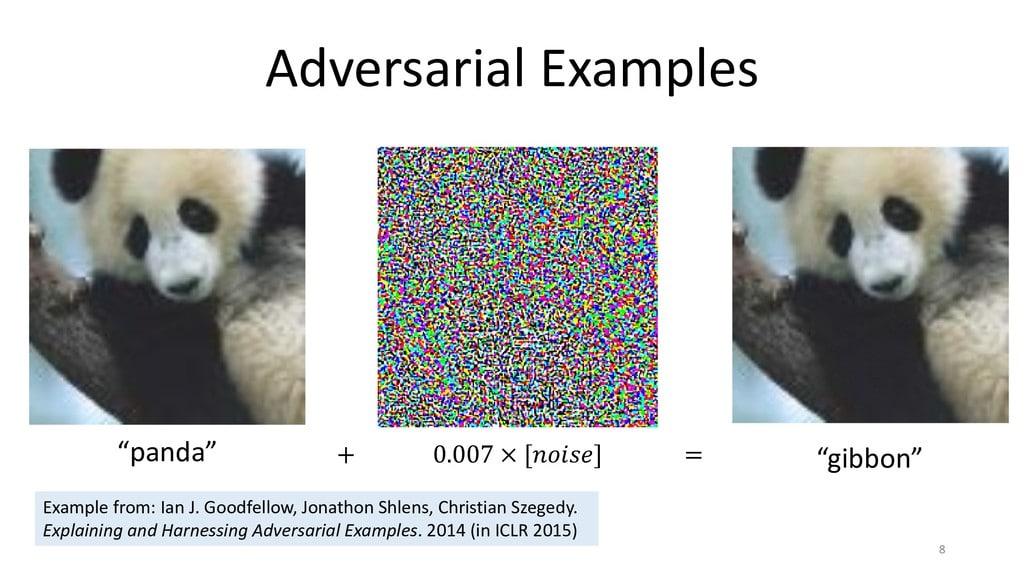

Adversarial example là các mẫu được tạo ra với những thao tác tinh vi mà mắt người không thể nào nhìn thấy được đã biến nó thành một hình ảnh hoàn toàn khác dưới con mắt kỹ thuật số của thuật toán machine learning.

Adversarial examples khai thác cách thức hoạt động của các thuật toán trí tuệ nhân tạo để phá vỡ nó. Trong vài năm qua, adversarial examples đã trở thành một lĩnh vực nghiên cứu tích cực khi vai trò của AI tiếp tục phát triển mạnh trong nhiều ứng dụng công nghệ. Ngày càng nhiều mối lo ngại rằng các lỗ hổng trong các hệ thống học máy có thể bị khai thác cho mục đích xấu. Khi bạn yêu cầu một người mô tả cách họ phát hiện ra một con gấu trúc trong một bức ảnh, họ có thể tìm kiếm các đặc điểm ngoại hình như tai tròn, các mảng đen quanh mắt, mõm, da có lông… Hoặc cũng có thể đưa ra các đặc điểm khác chẳng hạn như môi trường sống hay hình dáng cơ thể… Nhưng đối với một mạng nơ-ron nhân tạo, miễn là việc chạy các giá trị pixel thông qua phương trình cung cấp câu trả lời đúng, nó sẽ tin rằng những gì nó đang thấy thực sự là một con gấu trúc.

Nói cách khác, bằng cách điều chỉnh các giá trị pixel trong hình ảnh theo một cách phù hợp, bạn có thể đánh lừa AI. Trong trường hợp adversarial example mà bạn đã thấy ở đầu bài viết, các nhà nghiên cứu AI đã thêm một lớp nhiễu vào hình ảnh. Sự thay đổi này khó có thể nhìn thấy được bằng mắt thường. Nhưng khi số pixel mới đi qua mạng nơ-ron, chúng sẽ cho ra kết quả là Chris Evans. Trong vài năm qua, đã có rất nhiều nghiên cứu về hoạt động và tác dụng của học máy đối nghịch. Năm 2016, các nhà nghiên cứu tại Đại học Carnegie Mellon đã cho thấy việc đeo một chiếc kính đặc biệt có thể đánh lừa các mạng lưới thần kinh nhận dạng khuôn mặt để khiến họ trông giống với những người nổi tiếng.

Trong một trường hợp khác, các nhà nghiên cứu tại Samsung và các trường Đại học Washington, Michigan và UC Berkley đã chỉ ra rằng bằng cách thực hiện các chỉnh sửa nhỏ trên biển báo “STOP”, họ có thể biến chúng trở nên vô hình trước các thuật toán thị giác máy tính của xe tự lái. Hacker có thể sử dụng adversarial attack này để buộc một chiếc xe tự lái vào nguy hiểm và có thể gây ra tai nạn. Một trong những cách chính để bảo vệ các mô hình học máy chống lại adversarial examples đó là “adversarial training”. Trong adversarial training, các kỹ sư của thuật toán học máy sẽ đào tạo lại các mô hình của họ về adversarial examples để làm cho chúng trở nên mạnh mẽ hơn trong việc chống lại sự nhiễu loạn dữ liệu. Mặc dù adversarial training là một quá trình dài và tốn kém, mỗi ví dụ đào tạo phải được thăm dò để tìm ra các điểm yếu của adversarial, sau đó mô hình phải được đào tạo lại trên tất cả các ví dụ đó. Các nhà khoa học vẫn đang phát triển các phương pháp để tối ưu hóa quá trình phát hiện và vá các điểm yếu của adversarial trong các mô hình học máy. Bên cạnh đó, các nhà nghiên cứu AI cũng đang tìm cách để có thể giải quyết các lỗ hổng adversarial trong các hệ thống deep learning (tạm gọi là học sâu) ở cấp độ cao hơn.

Adversarial examples cũng là một lời nhắc nhở con người rõ ràng về việc trí tuệ nhân tạo và trí óc con người khác nhau như thế nào. Nếu bạn thích bài viết này, hãy chia sẻ nó với những người quan tâm và hãy thường xuyên truy cập website để có những thông tin mới nhất về lĩnh vực.