Fawkes và các kỹ thuật tương tự sẽ giúp bảo vệ bạn khỏi sự kiểm soát của các mô hình nhận dạng mặt người

Năm 2020 là một năm khởi sắc của Machine learning, chúng ta đã chứng kiến sự xuất hiện thực sự của nó, nơi mà các mô hình và thuật toán Deep learning có sẵn cho người dùng Internet, GPU rẻ hơn và sẵn có hơn bao giờ hết. Nhưng Deep learning cũng có mặt trái của nó. Mới đây, Thời báo New York đã đề cập đến clearview.ai trong một bài báo của Kashmir Hill, dịch vụ nhận dạng khuôn mặt không được kiểm soát đã tải xuống hơn 3 tỷ bức ảnh của mọi người từ Internet và phương tiện truyền thông xã hội, sử dụng chúng để xây dựng các mô hình nhận dạng khuôn mặt cho hàng triệu người mà họ không hề hay biết. Vậy làm cách nào để chúng ta tự bảo vệ mình trước các bên thứ ba trái phép này? Giải pháp đã được kiểm chứng là Fawkes – SAND, Đại học Chicago.

Phòng nghiên cứu SAND tại Đại học Chicago đã phát triển Fawkes, một thuật toán và công cụ phần mềm (chạy cục bộ trên máy tính của bạn) cung cấp cho mọi người khả năng hạn chế các bên thứ ba không xác định theo dõi trái phép họ bằng cách xây dựng các mô hình nhận dạng khuôn mặt từ các bức ảnh công khai có sẵn. Ở cấp độ cao hơn, Fawkes “đầu độc” những mô hình cố gắng nhận dạng người dùng, bằng cách đưa những thay đổi ẩn vào hình ảnh của người dùng và sử dụng chúng như con ngựa thành Troy để đưa “chất độc” đó đến bất kỳ mô hình nhận dạng khuôn mặt nào.

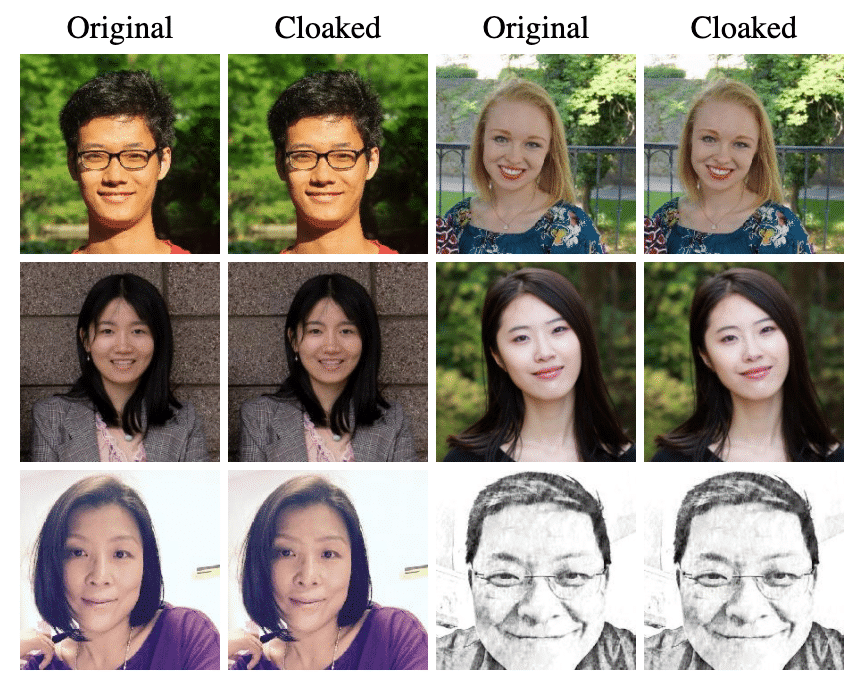

Fawkes lấy hình ảnh cá nhân của bạn và thực hiện những thay đổi nhỏ ở mức pixel mà mắt người không nhìn thấy được, trong một quá trình mà họ gọi là “che giấu hình ảnh”. Sau đó, bạn có thể sử dụng những bức ảnh đã được “che giấu” này một cách bình thường, chia sẻ trên mạng xã hội, gửi cho bạn bè, in hoặc hiển thị trên thiết bị kỹ thuật số, giống như cách bạn làm với bất kỳ bức ảnh nào khác. Tuy nhiên, sự khác biệt là nếu và khi ai đó cố gắng sử dụng những bức ảnh này để xây dựng một mô hình nhận dạng khuôn mặt bất kỳ, những hình ảnh này sẽ dạy cho các mô hình đó một phiên bản méo mó trông giống bạn. Hiệu ứng “che giấu” này không dễ bị con người hoặc máy móc phát hiện và sẽ không gây ra sai sót trong quá trình đào tạo các mô hình. Nhưng khi ai đó cố gắng nhận dạng bạn bằng cách đưa một hình ảnh gốc về bạn (ví dụ ảnh chụp ở nơi công cộng) cho các mô hình, nó sẽ không nhận ra bạn.

Fawkes đã được thử nghiệm rộng rãi và được chứng minh hiệu quả trong nhiều môi trường khác nhau, đặc biệt hiệu quả 100% chống lại các mô hình nhận dạng khuôn mặt hiện đại (Microsoft Azure Face API, Amazon Rekognition và Face ++). Dự án Fawkes do hai nghiên cứu sinh tại SAND Lab là Emily Wenger và Shawn Shan dẫn đầu, với sự đóng góp quan trọng của Huiying Li và Jiayun Zhang, các cố vấn của khoa là đồng giám đốc SAND Lab và các Giáo sư Neubauer Ben Zhao và Heather Zheng.

Nếu bạn thích bài viết này, đừng ngại chia sẻ với những người quan tâm. Hãy thường xuyên truy cập website hoặc tham gia các cộng đồng của Trí tuệ nhân tạo để có được những thông tin mới và chuyên sâu về lĩnh vực.